이 블로그에서 자주 소개는 안 했지만 제가 요즘 관심 있는 분야가 반도체입니다. 한국의 과거 현재 그리고 미래 먹거리가 될 것이 확실합니다. 다만 미국과 달리 한국은 비메모리 반도체 즉 GPU와 CPU 같은 시스템 반도체보다는 메모리 반도체만 잘 만듭니다.

2030년까지 시스템 반도체 세계 시장 점유율을 10%까지 끌어올리는 것이 목표라고 하는데 제 판단으로는 쉽지 않아 보입니다. 인구가 주는 것도 있지만 반도체 산업 방향성을 제대로 못 잡는 것 같기도 합니다. 2023년 메모리 반도체와 낸드플래시 반도체는 치킨 게임을 했습니다. 삼성전자 SK 하이닉스 엄청난 적자를 기록하면서도 원가 이하로 메모리와 낸드플래시를 팔고 있었습니다.

메모리 반도체가 파도처럼 수시로 수조 원의 수익을 내다가 수조 원의 적자를 내는 부침이 심합니다. 반면 시스템 반도체는 꾸준히 흑자를 내죠. 이런 상황이다 보니 나라 경제가 메모리 반도체 업황에 따라서 좌지우지하는 것도 큽니다. 1년 가까이 연속 무역 적자를 낸 이유가 메모리 반도체 영향이 큽니다.

챗GPT가 몰고 온 AI 반도체 열기의 온기를 쬐는 HBM 메모리

요즘 HBM 반도체가 뜨고 있습니다. HBM은 High Bandwidth Memory의 약자로 해석하면 고대역폭 메모리라는 뜻입니다. 요즘 사상 최고의 주가를 갱신하고 있는 GPU 맛집 엔비디아와 경쟁자인 AMD가 자기들에게 HBM 메모리 달라고 서로 난리입니다. HBM은 이름에 설명이 다 되어 있습니다. 그러나 이걸 왜 필요로 하는지 아는 분들은 많지 않죠.

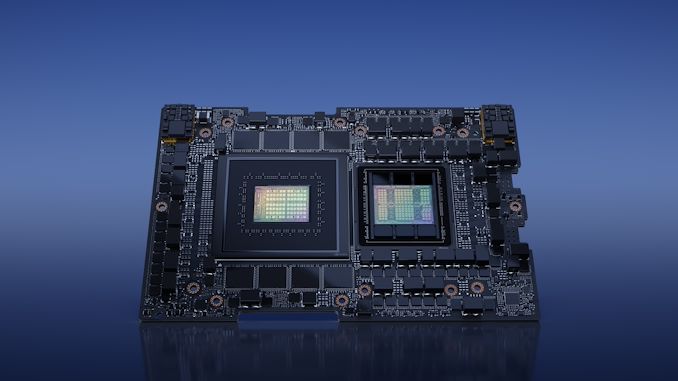

2023년 5월 엔비디아는 그레이스 호퍼 DGX GH200라는 슈퍼칩을 발표했습니다. 이 슈퍼칩은 GPU와 CPU를 넣어서 AI 기계학습에 최적화된 AI용 슈퍼칩입니다. AI가 요즘 대세죠. 챗GPT가 몰고 온 AI 열풍은 앞으로 더 거세질 겁니다.

제가 기술 마케팅 거품을 싫어합니다. 2000년대 초 유비쿼터스, 2010년 초의 3D TV, VR 기기, 3D 프린터, 메타버스 등등 수 많은 미래의 기술이라는 것을 외치는 걸 보면서 대부분은 좀 유행하다 잦아들겠다고 생각했고 거의 맞았습니다.

그러나 AI 열풍은 차원이 다릅니다. 미래가 아닌 현재를 바꾸고 있습니다. 요즘 챗GPT 돌려서 블로그 글 쓰는 사람들 엄청 많아졌습니다. AI가 만든 이미지로 뉴스 기사 삽화로 쓰는 언론사도 많고 최근에 나온 소라 AI는 동영상 제작자들까지 기겁하게 하고 있습니다. 그런데 그런 AI 기술을 이용하려면 엄청나게 빠른 계산을 하는 컴퓨팅 파워가 필요로 합니다.

빠른 계산을 하는데는 CPU와 GPU가 있습니다. CPU는 복잡한 계산을 하는데 최적화된 논리연산 반도체로 다양한 프로그램을 돌리는데 적합합니다. 반면 GPU는 이미지를 구현하고 동영상을 구현하는데 필요한 단순반복 연산에 적합합니다. 우리가 보는 사진과 동영상 하나하나가 테두리가 부드럽게 보이는 이유와 사진과 동영상을 구현하는 모니터 픽셀의 색상 값을 빠르게 계산할 수 있는 것이 GPU의 대량의 단순 반복 빠른 연산 때문에 가능합니다. CPU가 1명의 교수님이라면 GPU는 초등학생들로 사칙연산만 잘 합니다. 대신 초등학생이 엄청나게 많아서 사칙연산만 수천명의 초등학생이 계산을 한다고 생각하시면 됩니다.

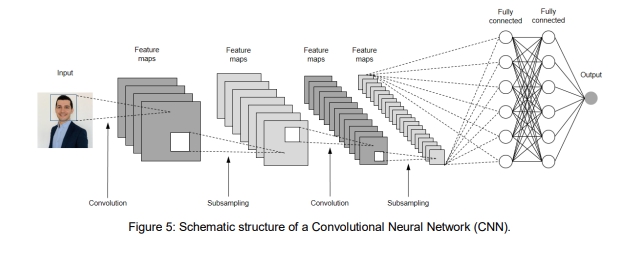

그래서 이 GPU는 복잡한 연산이 아닌 단순한 연산을 CPU보다 빠르게 하는 것이 장점이자 특징입니다. 그런데 암호화폐 계산도 그렇고 AI의 기계학습도 단순 반복 연산 작업의 연속입니다. 딥러닝의 계산을 보면 입력과 출력단이 있고 중간에 은닉층이 있습니다. 이 은닉층은 수많은 노드가 있습니다. 그리고 그 노드끼리 연결이 강하게 되었다가 느슨하게 되었다 하면서 수많은 생성 작업을 합니다.

이런 계산 방식은 인간의 뉴런 신경망과 비슷합니다. 실제로 인간 뇌에 있는 신경망에서 영감을 받아서 만들었다고 하죠.

인간 뇌 속에 있는 정보 전달을 담당하는 뉴런 같은 노드의 수가 많을수록 보다 뛰어난 AI 연산을 합니다. 이 노드의 수를 늘리려면 GPU의 빠른 연산 속도를 더 높이는 것과 동시에 한번에 많은 AI 연산을 하기 위해서 메모리도 크게 늘려야 합니다.

GPU와 CPU의 도우미 메모리 반도체

우리가 사용하는 컴퓨터의 구조를 최초로 구상한 사람은 '폰 노이만'입니다. 컴퓨터의 아버지입니다. 이분이 CPU와 메모리와 저장장치라는 컴퓨터의 기본 구조를 만들었습니다.

우리가 컴퓨터를 켜면 윈도우나 리눅스나 안드로이드나 iOS 운영체제가 빠르게 메모리에 올려집니다. 쉽게 말해서 부엌에 전원을 넣으면 거대한 주방 요리 다이가 생깁니다. 그리고 각종 요리 재료와 도구가 저장장치인 냉장고(SSD나 HDD)에서 나와서 요리를 할 수 있는 거대한 다이에 올려집니다. 이 거대한 요리 다이가 메모리입니다.

CPU나 GPU는 논리 연산 계산만 하는 도구입니다. 인간의 뇌라고 할 수 있죠. 우리 뇌는 죽지 않으면 꺼지지 않지만 GPU나 CPU는 전원을 수시로 껐다 켰다 합니다. 따라서 기억을 저장할 공간이 없습니다. 그냥 주어진 연산 계산만 빠르게 할 뿐이죠. 그냥 거대하고 빠르고 똑똑한 계산기라고 보시면 됩니다.

그런데 어떻게 무엇을 계산하느냐는 메모리에 올라간 프로그램의 방식대로 계산을 합니다. 여기에 계산(연산)을 하다가 잠시 킵해 놓아야 하는 데이터들을 메모리가 잠시 보관을 해줍니다. 그래야 다음 계산을 빠르게 해야 하니까요. CPU는 아주 복잡한 요리를 하는데 적합하고 GPU는 양파 까기, 계란 삶기, 볶기 등등 단순한 요리 작업을 빠르게 하는데 적합합니다.

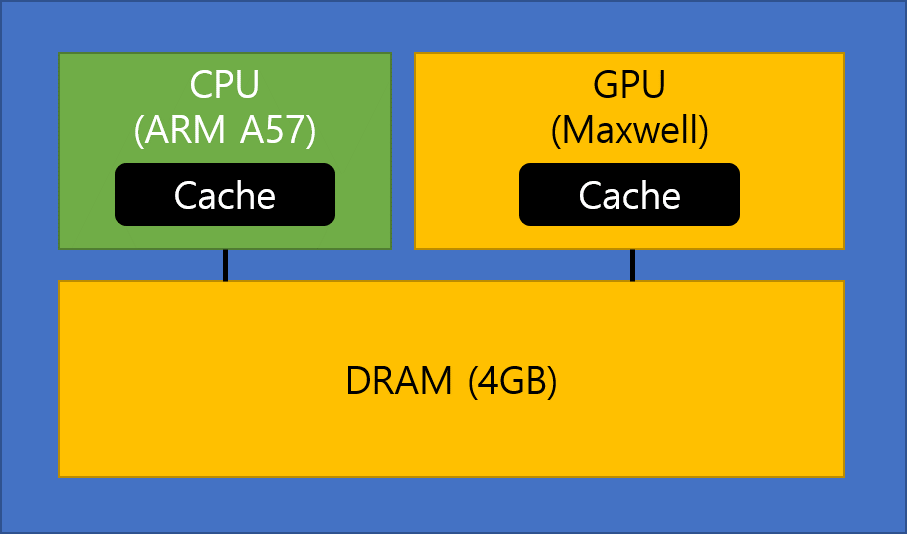

이 CPU와 GPU는 모두 메모리가 필요합니다. 메모리에 계산법(레시피)과 요리에 사용될 각종 데이터를 잠시 오려 놓아야 합니다. 그리고 그렇게 레시피 대로 요리 재료를 넣고 CPU와 GPU가 요리를 마치면 HDD나 SSD라는 저장장치에 저장을 하고 우리는 그 요리된 데이터를 맛있게 섭취합니다.

간단하게 생각하시면 됩니다. CPU와 GPU는 연산을 담당하고 연산에 필요한 도구나 데이터를 잠시 킵하는 저장 역할을 메모리가 하고 영구 저장은 HDD나 SSD가 합니다.

메모리 반도체 시장의 구세주 HBM 메모리 반도체

메모리와 GPU, CPU는 함께 일을 합니다. GPU와 CPU가 요리사라면 메모리는 요리를 할 수 있게 도와주는 다이와 선반과 레시피를 제공하는 역할을 하죠. 그래서 수시로 엄청난 데이터를 주고 받습니다. 그러나 이 데이터를 주고받는 통로가 좁으면 병목 현상이 일어나고 계산 속도가 떨어지게 됩니다.

AI 기계학습 연산은 단순반복 작업이고 엄청난 데이터를 주고 받아야 합니다. 이에 기존의 DRAM보다 빠르고 그러나 비싼 HBM 메모리를 찾게 되었습니다.

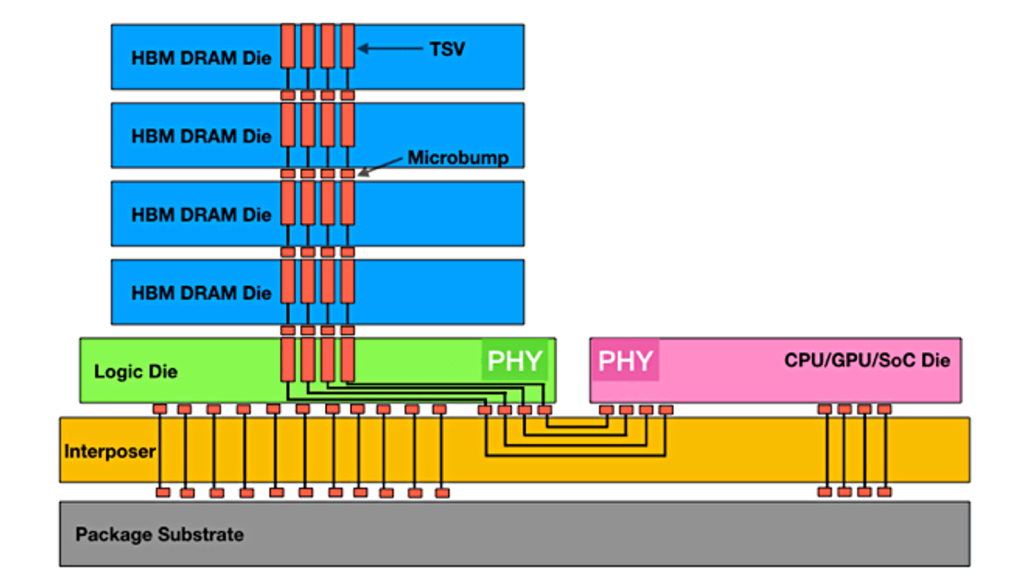

HBM 고대역폭 메모리는 기존 DRAM의 느린 데이터 전송 속도를 개선하기 위해서 나왔습니다. 기존 메모리 반도체와 다르게 아파트처럼 위로 DRAM을 쌓았고 TSV(Through Silicon Via)라는 기술을 이용해서 쌓아 올린 DRAM사이를 엄청나게 빠른 데이터 전송을 위한 통로를 만들었습니다. 그리고 GPU와 CPU 옆에 바싹 붙어서 보다 대량의 데이터를 빠르게 전송할 수 있게 만들어진 고성능, 고대역폭 메모리입니다.

이 HBM 메모리는 AI 광풍이 불기 전인 2017년 경에 이미 만들어졌었습니다. 삼성전자가 최초로 만들었지만 비싼 가격과 활용처가 많지 않아서 인기는 없었습니다. 그런데 AI 광풍이 불고 AI 반도체를 만들려면 메모리와 GPU가 보다 빠르게 통신을 할 수 있는 고대역폭 메모리를 요구하게 되었는데 마침 만들어 놓은 게 HBM 메모리라서 이걸 쓰고 있습니다.

쉽게 말해서 기존 메모리로도 작업이 원할할 때는 2차선(차선은 대역폭)으로 충분했습니다. 공장 자재 창고에서 작업장까지 2차선이면 충분했는데 공장을 확장하면서 작업자가 늘어나자 자재 창고의 자재를 빠르게 운송해야 했습니다. 이에 20차선으로 확장을 할 필요가 생겼습니다. 이 20차선을 제공할 수 있는 메모리가 바로 HBM입니다. 현재는 4세대인 HBM3가 초당 최대 819GB라는 데이터를 처리하고 있습니다.

이 HBM 메모리 시장은 SK하이닉스가 1위이고 삼성전자가 2위를 차지하고 있습니다. 뉴스에 따르면 SK하이닉스는 HBM을 꾸준히 개발을 했고 삼성전자는 이거 돈이 될까 하고 잠시 멈췄다가 다시 재가동하다 보니 시장점유율에서 밀렸습니다. 여기에 엔비디아와 불화설, TSMC과의 경쟁 관계 등등 GPU 제조업체들이 갑인 이곳에서 고전하고 있다는 소리도 들리네요.

그러나 삼성전자의 저력이 커서 조만간 삼성전자가 HBM 메모리 시장 1위를 차지할 것으로 보입니다. 최근에 보니 삼성전자가 12단 HBM3E를 개발했다고 하죠. 업계 최대 용량인 36GB을 저장할 수 있습니다. 반도체 광풍이 불어서 엔비디아와 TSMC도 주가가 팍팍 오르지만 삼성전자 주가는 미동도 안 하네요.

이래서 시스템 반도체나 각종 패키징 기술력을 키워야 한다는 소리가 높습니다. 반도체를 제조하는 걸 넘어서 그걸 제품화 하고 패키징 하는 디자인하우스 노하우는 대만에 비해서 한국이 많이 딸린다고 하죠. 여러모로 반도체 훈풍에 한국은 그 열기가 안 오는 건 아닌데 곁불이나 쬐는 느낌이네요.